Das akustische Modell beschreibt die Zusammenhänge zwischen den Merkmalsvektoren und den Wörtern des Vokabulars. Dies geschieht in der Regel in zwei Schritten. Zunächst werden die Wörter als Ketten von Grundeinheiten, zum Beispiel Phonemen, dargestellt. Phoneme sind die kleinsten bedeutungsunterscheidenden Lauteinheiten einer Sprache. In der Regel werden für die deutsche Sprache ca. 40 Einzelphoneme verwendet. Koartikulationseffekte können durch kontextabhängige Phonemmodelle besser berücksichtigt werden. Im zweiten Schritt wird dann die Verbindung zwischen Merkmalsvektoren und Phonemen durch Wahrscheinlichkeitsverteilungen beschrieben. Jedes Phonem wird wiederum durch ein Hidden-Markov-Modell (HMM) dargestellt. Dadurch werden die stark variierenden Sprechgeschwindigkeiten in die Berechnung einbezogen.

Ein HMM ist ein stochastischer endlicher Automat, der aus einer endlichen Menge von Zuständen mit je einer zugeordneten Wahrscheinlichkeitsverteilung (Emissionswahrscheinlichkeit), einem Startzustand, Ausgabesymbolen und Transitionen besteht. Jede Transition ist mit einer Übergangswahrscheinlichkeit und einem Ausgabesymbol verknüpft. Wenn eine bestimmte Transition gewählt wird, wird das zugeordnete Ausgabesymbol erzeugt. Die Besonderheit ist, daß die Ausgabe, also eine Folge von Ausgabesymbolen, nicht eindeutig durch die Transitionen bestimmt ist. Der Beobachter kann von außen nur die Ausgabe, aber nicht die Transitionen, die zu dieser Ausgabe geführt haben, beobachten. Dieses wird durch den Zusatz ''Hidden'' beschrieben.

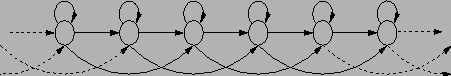

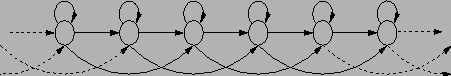

Ein in der Spracherkennung häufig verwendetes Transitions-Modell ist das Bakis-Modell [47]. Dabei stehen die Übergänge Loop, Forward und Skip zur Verfügung. Üblicherweise werden für Phoneme sechs Zustände verwendet. Die Zustände sind linear geordnet, um den zeitlichen Ablauf zu beschreiben. Der direkte Übergang (Forward) von einem Zustand zu seinem direkten Nachbarn kann als ''normale'' Sprechgeschwindigkeit bezeichnet werden. Das Wiederholen (Loop) oder Überspringen (Skip) von Zuständen modelliert die Geschwindigkeitsvariationen des Sprachsignals. Die Zustände werden mit Emissionswahrscheinlichkeiten beschrieben und die Übergänge mit Transitionswahrscheinlichkeiten. Das Ergebnis eines Durchlaufs des Automaten entspricht dann dem Produkt aus Transitions- und Emissionswahrscheinlichkeiten. Die Parameter der Verteilungen müssen aus einem möglichst großen Beispielvorrat heraus geschätzt werden.

Die Wahrscheinlichkeit, mit der die Beobachtungsvektoren ein Phonem beschreiben, wird durch die Optimierung des Produkts der Emissions- und Transitionswahrscheinlichkeiten ermittelt. Durch die Verwendung von kontextabhängigen Phonemmodellen kann die Erkennungsleistung signifikant gesteigert werden. Ein solches ist zum Beispiel das Triphon-Modell gegenüber dem kontextunabhängigen Monophon-Modell. Zur Verdeutlichung ein kleines Transkriptionsbeispiel (Phonemschreibweise) des Wortes ''Kaffee'':

Monophon: k a f e:

Triphon:

![]() e:

e:![]() (,wobei

(,wobei ![]() die Phonemgrenze darstellt)

die Phonemgrenze darstellt)

Für die lautsprachliche Realisierung eines Wortes können verschiedene Aussprachevarianten existieren. Ein Beispiel dafür ist das Wort ''Morgen''. Die Schreibweise basiert auf der SAMPA2.1-Notation: